|13代酷睿的这个小“挂件”,或将变革PC的AI生态

文章图片

文章图片

文章图片

众所周知 , 今年的12代酷睿处理器家族依靠大改的架构 , 以及显著提升的性能与能效比 , 帮助英特尔在市场中“挣”回了不少的脸面与份额 。 与此同时 , 由于12代酷睿与6000系锐龙显著的产品力提升 , 它们也让许多消费者重新开始关注PC处理器的更新换代信息 , 并筹划起了自己的“换机计划” 。

当然 , 我们三易生活在这些人当中 。 然而就在最近 , 当我们正满怀希望地查找有关下一代酷睿处理器的官方预告信息时 , 一行不太起眼的内容却吸引了我们的注意力 , 并引发了一些别样的思考 。

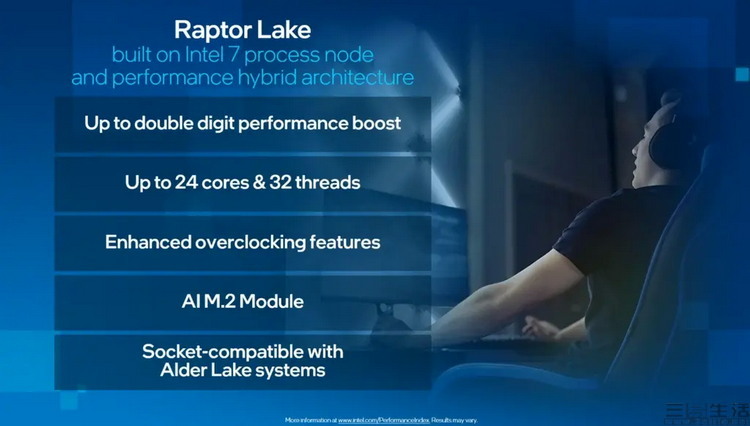

正如大家所见 , 这是一张大概率来自英特尔官方 , 针对13代酷睿的技术特性预告 。 在相关媒体的报道中 , 多半都将重点集中到了诸如“采用Intel 7制程”、“最大24核心32线程”、“最大两位数的性能提升”、“更强的超频功能”、“与12代酷睿的插座兼容”等 , 更容易理解、也早已被外界所熟知的项目上 。

【|13代酷睿的这个小“挂件”,或将变革PC的AI生态】然而在我们三易生活的眼中 , 真正值得关注的却是这张PPT里一个很少提及的项目——“AI M2 Module” 。

什么是“AI M2 Module”?直译就是“AI M2模组” , 也就是一种通过M2接口插在主板上、可以提供额外AI加速能力的“小型AI计算卡” 。

请注意 , 这类产品本身并非什么新奇玩意 , 只要接触过AI开发的朋友就会知道 , 英特尔近年来其实一直都有推出类似的低功耗AI加速计算设备 。 这些设备基于英特尔自研的低功耗AI芯片 , 接口既有M2规格的、也有PCIE的 , 甚至还有直接采用U盘造型的 , 只需往电脑上一插就能起到“AI加速”的作用 。

但问题就在于 , 这样的设备过去通常都只是供开发者使用、用来在传统PC上“模拟”一些特定设备环境 。 比如要开发一个供自动驾驶汽车使用的视觉识别代码 , 就可以使用英特尔的“AI计算棒” , 去模拟车载电脑的AI加速单元 , 由于两者的架构相似、能够运行相同的代码 , 所以这种小型AI加速单元对于部分开发者来说 , 是很实用、甚至可以说是非常有必要的 。

可当类似的设备出现在针对普通消费者的、下一代处理器平台预告信息中时 , 却未必是件好事 。

为什么我们会这么讲?要说明这个问题 , 我们首先以时下主流的智能手机平台为例 。

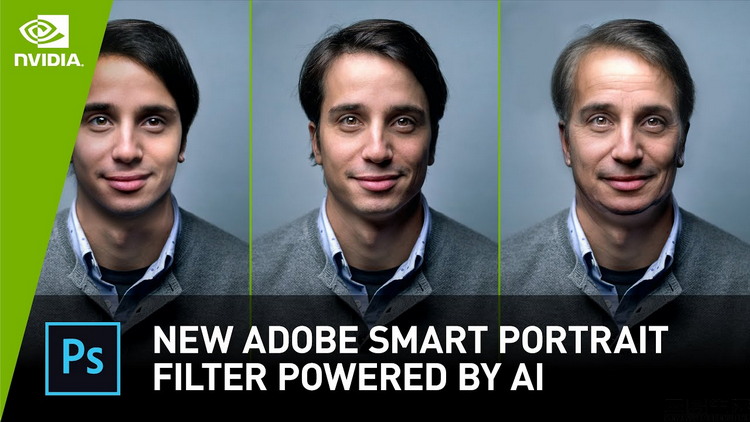

众所周知 , 现在的智能手机SoC普遍都集成了AI加速能力 , 而手机上的主流应用也开始越来越多地适配这些SoC的本地AI计算功能 。 比如某些翻译软件、部分输入法 , 第三方拍照或修图APP等 , 现在都可以被手机上的AI单元“加速” , 从而带来更高的执行效率 , 或是更好的隐私保护能力(指本地AI执行 , 无需联网) 。

那么PC平台的情况又如何呢?追溯历史不难发现 , 其实PC平台很早就具备了“AI加速”相关功能 。 比如说2019年发布的10代酷睿-X系列、10代酷睿移动版 , 2020年发布的11代酷睿移动版、2021年发布的11代酷睿桌面版处理器 , 以及2022年的整个12代酷睿家族 , 都带有为加速AI代码(16位半精度计算)而设计的“DL Boost”指令集 。

更不要说在GPU领域 , 早在2017年NVIDIA方面就已经推出了内置AI加速单元(Tensor Core)的Titan V显卡 。 而到了后来的RTX20、RTX30系里 , Tensor Core和AI加速计算能力更是已经成为了“标配”特性 。

相关经验推荐

- 软件|比微信还要早!这款陪伴我们十五年的聊天软件正式谢幕

- 触控|你要的无线桌面我已经打造成功!想做到极致简约,升降桌必须要有

- 苹果|为什么说懂行的人买苹果华为,半懂买小米,不懂买荣耀,这有道理吗

- 大v|为什么网上有那么多工资一万多的人,现实中大多数工资才四五千?

- |为什么说华为才是未来?看看美国高通的态度,一切就解释通了

- 相机|都卖四五千的价格,到底谁才是2022年的拍照手机联名之王?

- 微信|马化腾窃喜!微信的最强劲敌宣告停运,8400万打了水漂

- 小米科技|小米都不敢这么“玩”!杀人诛心发布99元小家电,美的:扰乱市场!

- iPhone|只会耍嘴炮的手机消费者,等的永远是下一台iPhone

- 机器人|“铁了心”想重返中国?国际巨头目的明显,这次目标多半指向华为