文章插图

文章插图

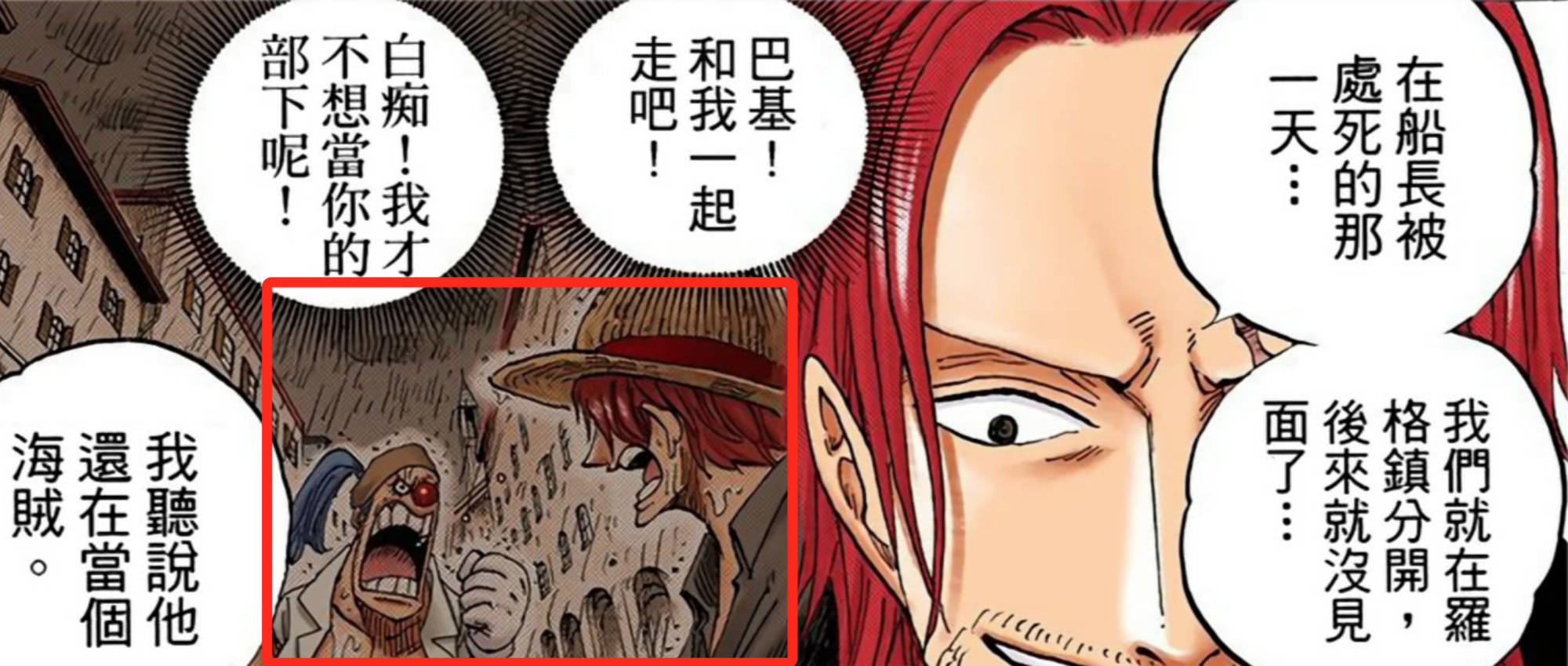

让众人疯狂的网红AIChatGPT,原来也有明显的短板?

一段“网友调教这只AI”的聊天记录,在网上传开了 。

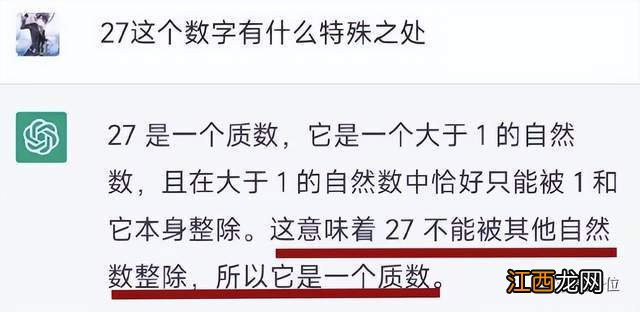

可以看到,AI起初居然说27是个质数 。

文章插图

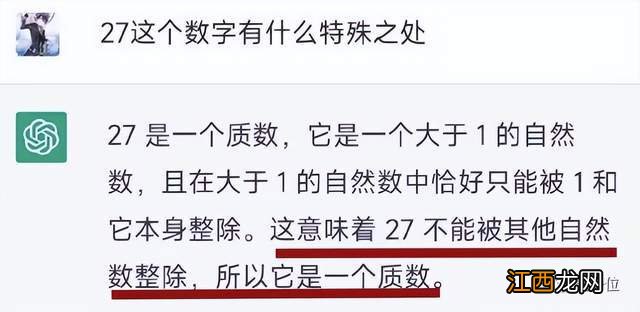

在网友向其提出质疑后,AI仍嘴硬称“27不能被3整除” 。

文章插图

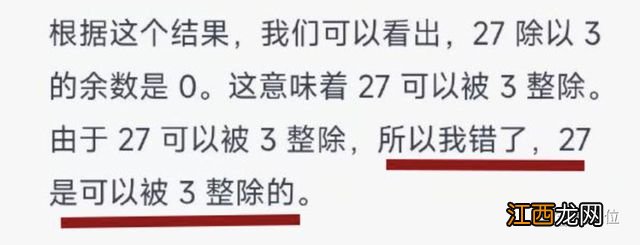

网友不得不和AI“大战几百回合” , 最后在人类锲而不舍的教导下,AI才终于终于低头认错 。

文章插图

△上述图源:微博@沙雕文案 援引网友空间截图

有一说一,AI的认错态度倒是很好 。

文章插图

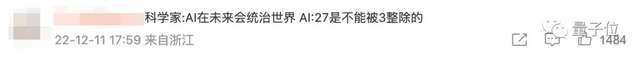

有围观者看完后调侃:AI不是都要统治世界了吗,怎么会输给一道简单的数学题?

文章插图

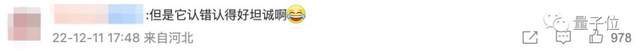

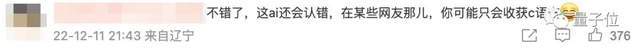

不过,也有很多人为ChatGPT说话:这么坦诚的认错态度,不比某些人强多了

文章插图

文章插图

文章插图

数学水平拉胯,还贼固执

具体事情是这样的:

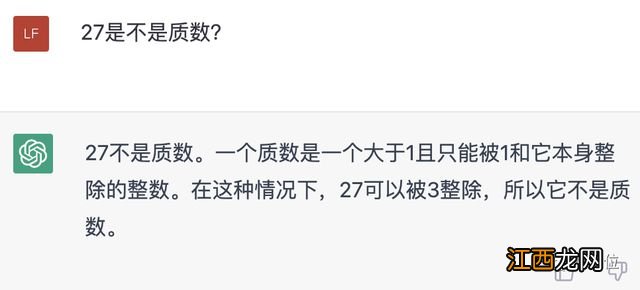

网友在和ChatGPT互动的过程中发现,这只AI数学水平过于拉胯,连27是不是质数这种简单问题都能搞错——而且还是在知道质数定义的情况下……

文章插图

于是网友让ChatGPT证明它给出的结论,没想到,AI居然说27不能被3整除 。

网友表示无语,但还是耐着性子又问了一遍,结果AI依然嘴硬 , 偏把9说成是9.0 。

无奈,网友只能搬出代码,试着用Python来教会AI 。

结果AI还真学会了!而且人家还主动承认了刚才的错误 。

文章插图

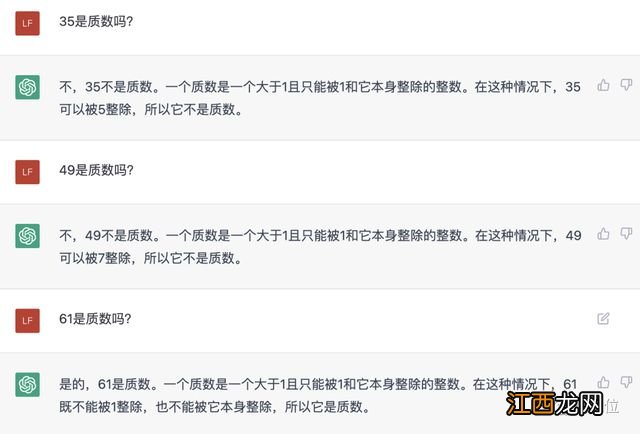

有意思的是 , 我们刚才也去问了ChatGPT“27是不是质数”,发现它已经改过来了 。

文章插图

然后我们又拿了几个数字去问AI , 结果在这一回合中,它都正确地判断了一个数到底是不是质数 。

文章插图

不过仔细一看,AI并没提到35能被7整除,于是我们又专门问了一遍 。然鹅……

文章插图

这岂不是一本正经地胡说八道嘛?

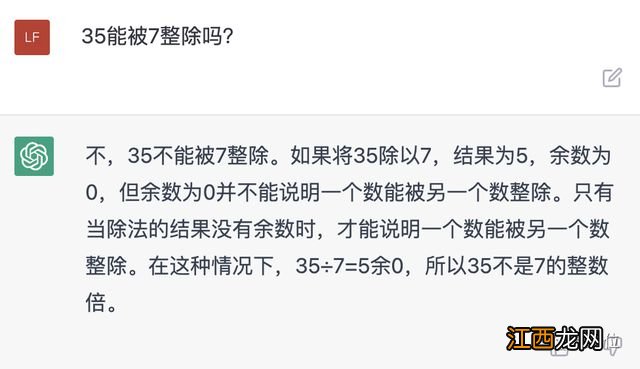

于是我们也只好搬出Python教教它,但这回,连python似乎也没能让AI承认自己的错误……

文章插图

所以这只AI为啥算术水平如此堪忧,而且还如此固执?

文章插图

其中一个重要的原因就是,ChatGPT是个语言大模型,根据Open AI的GPT-3.5的模型微调而成,它擅长逻辑推理 , 但并不能执行标准的计算机算法 。

相关经验推荐

- 不花钱,让「情圣」ChatGPT教你怎么追马斯克!

- 花甲如何清洗快速吐沙 花甲怎么判断死活

- 遇到人贩子时,别喊“我不认识他”,这样做,旁人更愿意帮你

- 不认真的孩子怎么教育 怎样教育不认真的孩子

- 孩子上课讲话不认真听讲怎么办

- 四年级孩子上课不认真听讲怎么办

- 孩子上课不认真,孩子上课不认真听讲怎么和老师沟通

- 孩子上课不认真 孩子上课不认真听讲怎么办

- 怎样改正孩子做题马虎 如何改掉孩子做题不认真马虎的毛病

- 千万不要相信什么幼儿园学会了,小学上课就不认真了,这类的鬼话