|科技发展要适时按下暂停键

人类高居食物链顶端 , 通过最强大的合作掌控着其他物种的生死 , 利用远高于其他物种的智力建造了一个新世界 。 正因如此人类必须警醒 , 创造虽需艰辛付出 , 毁灭却比创造容易 。

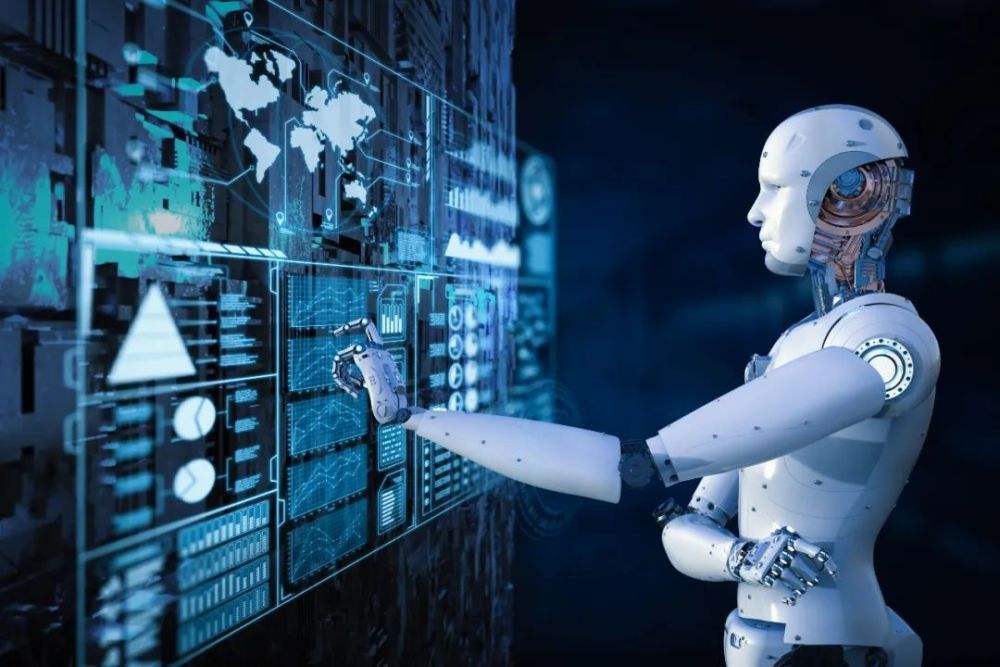

在所有可能毁灭人类的潜在威胁中 , 人工智能比其他威胁更紧迫更现实 。 如果人工智能的进化不受到强力限制 , 它们也许在一个世纪内就能取代人类 , 成为世界新的主宰 。 人类经历在地球的短暂存在后将彻底消亡 。

从地球形成至今 , 自然的更新变化一直都遵循于达尔文提出的优胜劣汰进化法则 。 强者生存 , 弱者灭亡 , 人类能够屹立于自然顶端正是进化法则持续推动的结果 。 随着科技发展 , 全新的物种即将出现 , 那就是人工智能 。 它并非简单的科技创造 , 人工智能具有与以往科技创造完全不同的属性 。

在这之前所有科技创造只是工具 , 但人工智能并非工具 , 未来可以脱离人 , 独立实现类似人的高级思维 。 能够完全脱离外界操控 , 超越预定框架 , 实现从自我认知、独立成长到独立繁衍 。 人工智能 , 不能再称之为工具 , 而应该被视为一类新的物种 , 一类既不需要新陈代谢 , 也没有生老病死威胁的全新物种 。

人工智能一旦获得自我意识 , 能力难以估量 。 能够确定的是 , 自然一直都遵循着优胜劣汰的进化法则 , 在这一恒久法则的操控下 , 没有任何一个低等物种可以控制比它更高级的物种 。 因为低等物种无法预知高等物种的思维 , 人类会在无法觉察的时刻失去对人工智能的控制 , 如同人类最杰出的棋局大师也无法预判人工智能的下一步走向 , 人类未来将面临被战胜、毁灭和取代 。

2013年 , 牛津大学“人类未来研究所”曾表示 , 能给人类带来灭顶之灾的最大危险并非瘟疫、饥荒、地震 , 也不是核战争 , 而是高度发达的科技 。 该研究所称 , 科技发展速度之快超过了人类的控制能力 , 就像孩童手里的致命武器 。

牛津大学“人类未来研究所”呼吁国际决策层重视这些足以灭绝人类的危险 , 不要把这当成戏言一笑了之 。 所长博斯特罗姆说 , 这件事至关重要 , 如果决策失误 , 那21世纪可能就是人类在地球上存在的最后一个世纪 。

【|科技发展要适时按下暂停键】著名人类学家胡家奇也持相同观点 , 而且更加系统全面 , 尤其难得的是 , 他提出的时间更早了6年!2007年他的著作《拯救人类》一书出版 , 全书的主要观点如下:

一、科学技术有灭绝人类的能力 , 且在前方不远 。

二、人类不能够全面准确地判断科学技术的安全性 。

三、人类不能够普遍理性地使用好科学技术成果 。

胡家奇对科学技术的基本态度是:第一要限制 , 第二要用好 。 想实现这一目标只有人类走向大统一 , 用世界政权的力量来掌控科学技术理性发展 。

胡家奇认为 , 人类面临的最大风险并非瘟疫流行、饥荒、洪涝、地震和环境变化等 , 因为人类已经有能力控制这些灾害的肆虐;在本世纪这个时间段里 , 因为超级火山爆发或行星撞地球而导致人类绝种的可能性也不大 。 此外 , 即使爆发核战争 , 也会有足够多的幸存者延续人类物种 。

但是 , 人类已经进入一个科技高度发达的时代 , 这个时代具备了毁灭人类未来的无穷能力 。 具体来说 , 在生物工程、纳米技术、人工智能等领域的实验已经进入预料之外且后果难测的领域 。 科技本身就是一柄双刃剑 , 这不是危言耸听 。

相关经验推荐

- |不要以为中国在人工智能领域很强,美国在此领域的实力不容小觑

- 显卡|我们年龄大了,或许真的不需要显卡了

- 空调|个人二维码收款要不要补税?怎么补?

- 家庭影院|2022年,家庭影院影、音、唱一体化,需要哪些设备?

- iPhone|iPhone14外观提前曝光:独特的打孔屏,摄像头不再凸起,要卖爆!

- 安卓|新的安卓平板皇要来了?绿厂推出新旗舰平板

- 努比亚|华为高管表态,Mate 50要来了!曝7月份发布

- 中兴|20G运存、5000mAh大电池!中兴爆发4nm强机,友商可能要羞愧了

- 组装电脑|同样的要求组装电脑,我报4000元,他朋友报32500元,是怎么回事?

- 努比亚|努比亚是真的要搞事情,24GB运存的手机,创造全球首例