作者的第三组贡献主要为分数建模(score-modeling)神经网络的训练 。

这部分继续依赖常用的网络体系结构(DDPM、NCSN) , 作者通过对扩散模型设置中网络的输入、输出和损失函数的预处理进行了原则性分析,得出了改进训练动态的最佳实践 。

比如使用依赖于σ(noise level)的跳跃连接对神经网络进行预处理 , 使其能够估计y(signal)或n(noise) , 或介于两者之间的东西 。

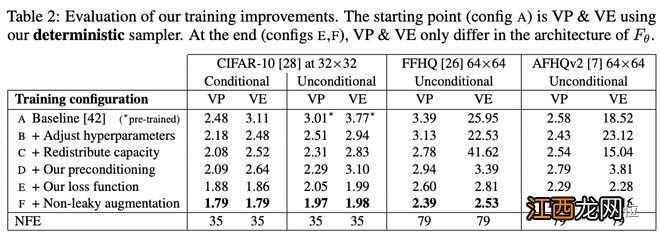

下表具体展示了模型彩英不同训练配置得到的FID分数 。

文章插图

作者从基线训练配置开始,使用确定性采样器(称为配置A) , 重新调整了基本超参数(配置B) , 并通过移除最低分辨率层 , 并将最高分辨率层的容量加倍来提高模型的表达能力(配置C) 。

然后用预处理(配置D)替换原来的{cin,cout , cnoise,cskip}选项 。这使结果基本保持不变,但VE在64×64分辨率下有很大改善 。该预处理方法的主要好处不是改善FID本身,而是使训练更加稳健,从而将重点转向重新设计损失函数又不会产生不利影响 。

【DeepMind谷歌研究员力荐:扩散模型效率&生成质量提升窍门】VP和VE只在Fθ的架构上有所不同(配置E和F) 。

除此之外,作者还建议改进训练期间的噪声级分布,并发现通常与GANs一起使用的无泄漏风险增强(non-leaking augmentation)操作也有利于扩散模型 。

比如从上表中,我们可以看到:有条件和无条件CIFAR-10的最新FID分别达到了1.79和1.97,打破了之前的记录(1.85和2.1046) 。

更多细节欢迎查看论文原文:

https://arxiv.org/abs/2206.00364

参考链接:

https://twitter.com/sedielem/status/1532466208435494930?s=12&t=Uzg6OWwe5AgXHSBrzlnFrg

相关经验推荐

- 影之诗国际服谷歌无法联动 影之诗怎么联动谷歌

- 航空业的复古时代?谷歌创始人的秘密项目:电动飞艇

- 谷歌推新绩效考核体系 或有超过1万名员工不达标

- 带谷歌云业绩翻几番,CEO库里安的秘诀是什么?

- 谷歌万国觉醒国际服怎么登,万国觉醒国际服怎么登录

- 影之诗怎么解绑谷歌 影之诗怎么解绑steam

- 影之诗怎么解绑谷歌,影之诗谷歌账号联动失败

- 华为怎么安装谷歌商店 怎么安装谷歌商店

- 苹果11怎么关谷歌浏览器 苹果11怎么关谷歌

- 影之诗怎么联动谷歌,影之诗谷歌解绑