在新的利润结构下,OpenAI的投资者最多可以赚取其原始投资的100倍,超过这个数字的剩下的钱将用于非营利性事务 。

2019年底,OpenAI宣布与微软合作,微软向这家公司投资了10亿美元 。OpenAI表示,它将向微软独家授权技术 。

文章插图

微软表示,通过GPT-3模型打造出的商业和创造潜力是无限的 , 很多潜在的新能力和新应用,甚至超出了我们的想象 。

比如在写作和作曲上、在描述和总结大块长篇数据(包括代码)上、在将自然语言转换为另一种语言等领域,GPT-3能够直接激发人类的创造力和聪明才智,未来的局限可能在于我们自己的想法和方案 。

这种伙伴关系,让微软能够与谷歌旗下同样风头正劲的AI公司DeepMind竞争 。

去年,OpenAI发布了一个人工智能画作生成工具:Dall-E 。

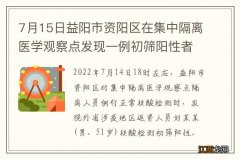

文章插图

Dall-E是一个人工智能系统,可以根据图像的描述创造出逼真的图像,甚至能够达到相当的艺术水准 , 11月,OpenAI发布了该程序的更新版本,Dall-E 2 。

虽然OpenAI的聊天机器人在过去一周已经「起飞」,但该软件的更新版本可能最快会在明年才能发布 。

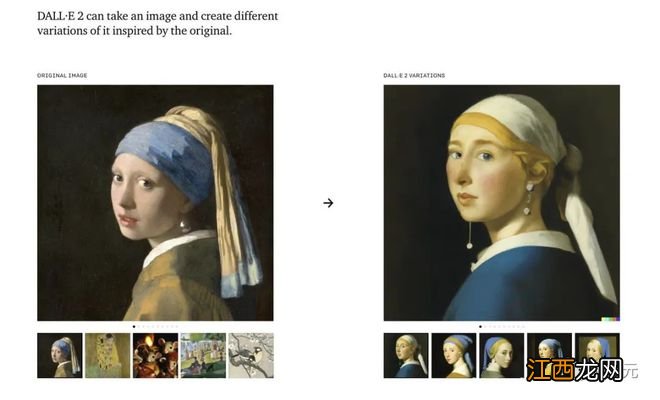

文章插图

11月30日,作为演示模型发布的ChatGPT算得上是OpenAI的「GPT-3.5」 。该公司计划接下来发布完整版的GPT-4 。

与此同时,马斯克还在发表评论:

文章插图

他在回复Sam Altman在谈论ChatGPT的推文中称,我们离强到危险的AI的诞生已经不远了 。

揭秘爆火ChatGPT后的功臣:RLHF

而要说ChatGPT的爆火,离不开它背后的功臣——RLHF 。

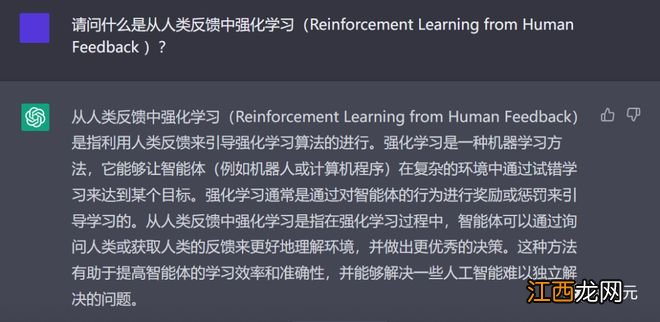

OpenAI的研究人员,是使用与InstructGPT相同的方法——来自人类反馈的强化学习(RLHF)来训练ChatGPT模型的 。

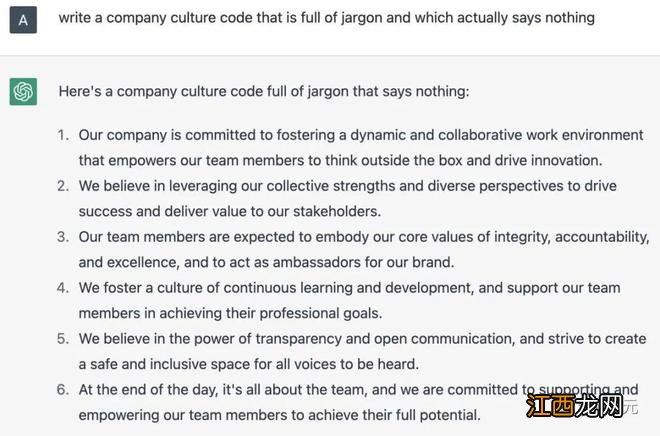

文章插图

ChatGPT用中文解释什么是RLHF

为什么会想到从人类反馈中强化学习呢?这就要从强化学习的背景说起 。

在过去几年里 , 语言模型一直是通过人类输入的提示生成文本的 。

然而,什么是「好」的文本呢?这很难定义 。因为判断标准很主观,并且非常依赖于上下文 。

在许多应用程序中 , 我们需要模型去编写特定创意的故事、信息性文本片段,或可执行的代码段 。

而通过编写一个损失函数来捕获这些属性,又显得很棘手 。并且,大多数语言模型仍然使用的是下一个标记预测损失(例如交叉熵)进行训练 。

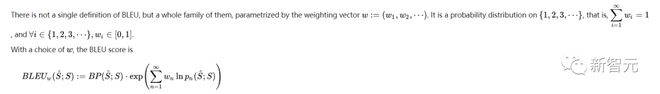

为了弥补损失本身的缺点,有人定义了能够更好地捕捉人类偏好的指标,比如BLEU或ROUGE 。

文章插图

但即使是它们 , 也只是简单地将生成的文本与引用进行比较,因此也有很大的局限性 。

在这种情况下,如果我们使用生成文本的人工反馈作为损失,来优化模型,不是很好吗?

就这样,从人类反馈中强化学习(RLHF)的想法诞生了——我们可以使用强化学习,直接优化带有人类反馈的语言模型 。

文章插图

ChatGPT用英文解释什么是RLH

是的,RLHF使语言模型能够将在一般文本数据语料库上训练的模型,与具有复杂人类价值观的模型对齐 。

相关经验推荐

- 懂不懂歌词 懂不懂歌词分配

- 6种毁掉孩子的教育方式六种不良教育 6种毁掉孩子的教育方式是什么

- 蓝莓是不是越大越好 蓝莓吃了有哪些好处

- 豇豆不熟会中毒吗 豇豆中毒多久有反应

- 油豆腐怎么保存不易坏 怎么挑选好的豆腐

- 便秘吃什么最快排便 便秘的症状虚实不同

- 郭子仪什么水平 郭子仪为什么功高不自傲

- 紫生菜不能同什么搭配

- 怀孕什么都不想吃怎么办 怀孕什么都不想吃怎么做

- 姜枣茶一次的量是多少 隔夜的姜枣茶可不可以喝