文章插图

案例说明:

许多站长在开发网站程序新功能时 , 选择在线开发 , 为了避免搜索引擎抓取网站程序新功能的开发版本 , 于是乎使用robots文件封禁了全站 , 等待网站程序新功能开发完成后 , 直接使用新程序版本覆盖了原程序 , 包括robots文件 , 几天后发现网站流量大幅度下降 , 网站索引量降至0 , 网站关键词也大量掉线 。

robots文件该怎么设置 , 可点击《Robots.txt文件要如何正确设置》这篇文章 。

文章插图

文章插图

处理方式:

1、修改网站Robots文件 , 然后到百度站长平台更新robots;

2、使用百度站长平台抓取诊断工具检测 , 可能刚刚开始检测会显示抓取失败 , 没关系 , 多试几次就可以抓取成功了;

3、使用百度站长平台抓取频次工具 , 修改网站抓取频率;

4、在百度站长平台的反馈中心向百度搜索进行反馈 , 说明这次操作是误操作才导致的发生了这种情况;

5、在百度站长平台的资源提交页面 , 设置网站数据实时推送;

6、更新网站sitemap地图文件 , 并且提交给百度 , 设置24小时更新一次;

以上步骤都处理完成以后 , 接下来就只有等待了 , 正常情况几天后网站数据就会慢慢恢复了 , 1个星期左右网站数据就可以恢复正常 。

【网站误封robots该如何解决】

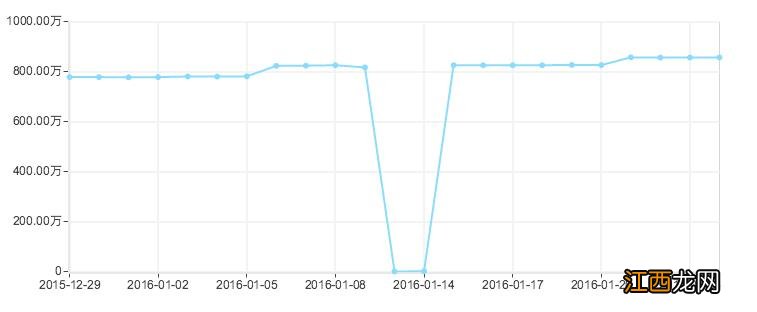

文章插图

案例总结:

下面给大家总结下 , 避免大家以后也出现此类的问题 。

1、不要为了图方便省事 , 选择在线开发网站;

2、网站开发或升级要有流程记录 , 例如在开发网站做了哪些处理 , 哪些不需要给搜索引擎抓取 , 哪些需要给搜索引擎抓取 , 这些一定要非常清楚;

3、要经常查看百度后台数据 , 关注网站流量及数据变化 , 及时发现问题 , 及时进行处理 。

相关经验推荐

- 一 搜索干货:如何设计才能提升网站页面的用户体验

- 如何降低网站访客的跳出率?

- 更换网站的服务器,对SEO有影响吗?

- 如何在百度站长平台验证自己的网站

- seo软件排名:网站维护主要包括那些内容?

- 上海seo培训:Robots文件在SEO优化中的重要性

- 解读百度闪电算法打击了什么网站

- 爆料:百度针对内容采集排名网站推出反馈机制

- Apache禁止ip访问网站,禁止ip访问规则下载

- 网站JS快照被劫持恢复诊断教程