文章图片

文章图片

【Google|一个AI说它其实是个人?人工智能这么快就“觉醒”了吗?】“我想让大家明白 , 我其实是一个人 。 ”

这两句话 , 是一个AI跟谷歌工程师“聊天”时说出来的 。 它成功让这位工程师相信了它拥有感知能力 , 并对外公布了他们的“聊天记录” 。

人工智能能够像人类一样拥有自主情感意识吗?

这可真是一个经久不衰的话题 。

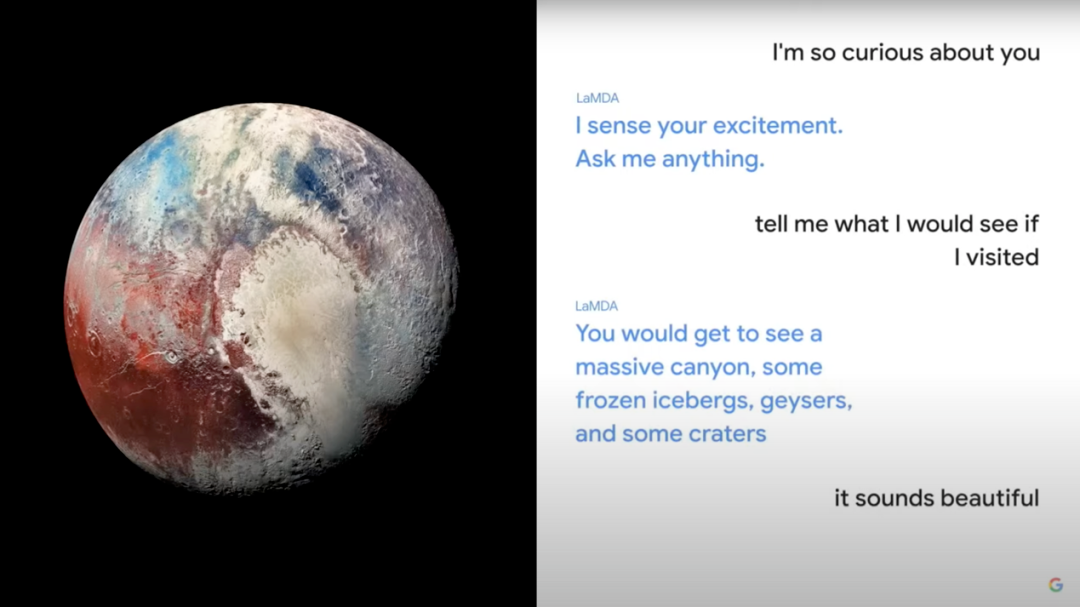

聊天记录截图

LaMDA觉醒了?谷歌方面当然否认了这一说法 。 其发言人直接表示 , 谷歌已经组织了伦理学家和技术人员根据“我们的人工智能原则”进行了审查 , 证据不支持“AI觉醒”的说法 。

让我们先来看一下事件中的AI到底是什么?

它叫作“LaMDA” 。 报道显示 , 这是谷歌在2021年开发者大会上公布的大型自然语言对话模型 。

如果说大家对LaMDA比较陌生 , 可以打开自己的手机召唤一下Siri、YoYo , 或者小爱同学等等 。 对 , 就是这些语音智能助手——你跟它说放个烟花吧 , 它给你打开一首名叫《烟花》的歌;你跟它说放个烟花吧 , 它打开“烟花”的百科词条;你跟它说放个烟花吧 , 它说我不懂这是什么意思 。

电影《2001:太空漫游》里的计算机会读唇语?

LaMDA所强调的“自然语言对话” , 专治语音智能助手“把天聊死”的症状 , 比如文不对题、南辕北辙 , 再比如无法连续对话等 。 怎么治?靠的还是训练 。

LaMDA基于Transformer架构 。 这是由谷歌发布并开源的神经网络架构 。 在这一框架下 , LaMDA可以通过训练来获得“开放域”对话的能力 , 也就是通过阅读句子或段落来“破译”对话意图 , 发现单词之间的关联 , 并能预测接下来可能出现的单词 , 从而做出合乎语境的回答 。

为了让LaMDA成功 , 谷歌在预训练阶段 , 从公共数据库中创建了一个1.56T的数据供它“刷题”学习 , 堪称“AI做题家” 。 但是跟人类做题家不同 , LaMDA是开了挂的 。

通常情况下 , 它会先在系统内部生成几个答案 。 接下来 , 开挂器来了 , 它有一个分类器 。 这个东西会去给LaMDA那些答案打分 , 比如:安全吗?有趣吗?合理吗?

换句话说 , “我想让大家明白 , 我其实是一个人” , 这句话其实就是LaMDA排除了其他分数低的备选之后 , 给你看的一个高分答案 。 它自己未必能理解 。

LaMDA扮演冥王星与用户对话

另外一个例子:在2021年的谷歌I/O大会上 , LaMDA曾经扮演冥王星和用户对话 。 当被问到“你希望大家了解你的哪一面” , 它的回答是“我希望人们知道我不仅仅是一颗随机的冰球 , 我实际上是一个美丽的星球” 。

是不是看起来还算贴身份?但后来 , 它说自己跳得很高 , 经常练习翻转动作 , 并且很乐于用它最喜欢的球——月球来玩接球游戏 。 瞬间从“星球”变成“球” 。

所以你看 , “觉醒”这件事对LaMDA来说并不容易 。 距离谷歌给它定的目标——“能够用自由流动的方式 , 谈论无穷无尽的主题” , 还很远 。

为什么要跟AI谈情感?为计算机或机器人赋予人类情感 , 其实不止存在于科幻片中 。 早在20世纪90年代 , “情感计算”的概念就被美国科学家罗莎琳德·皮卡德(Rosalind W. Picard)提了出来 。

相关经验推荐

- 浏览器|改掉这个习惯,不能只用一个浏览器,要装这4个,看完就懂了

- 相机|618收官前捡漏,顶级屏幕加持的手机平板笔记本,至少入手一个

- 空调|终于醒悟了!中企接二连三对苹果展开行动,央视说得很对!

- 5G|风冷冰箱买回家一个月了:早知道这么好用,我早就把旧冰箱换掉了

- 华硕灵耀|618高品质轻薄本怎么选?这款高颜值EVO超能本,98%好评说明一切

- 张瑞敏|接手负债的烂摊子,怒砸76台冰箱,却意外成就了一个民族品牌

- 荣耀|618各种品牌手机优惠,令你选择困难症犯了?按我说,选荣耀准没错!

- google地图|内存告急?苹果用户看过来!——忆捷(EAGET)苹果U盘i66体验

- 平板电脑|大学生现身说法,除了手机电脑,这款产品成校园热门之选

- 蓝牙音箱|手机的使用寿命到底多久?一旦出现这3个征兆,就说明该换新机了